-

[Spark] Pyspark 데이터프레임을 JSON 딕셔너리로 변환하기DataProcessing/Spark 2021. 3. 1. 21:59

Dataframe => JSON 변환하기

1. 데이터프레임에서 toJSON 함수와 collect하면 전체 dataset을 string으로 반환한다.

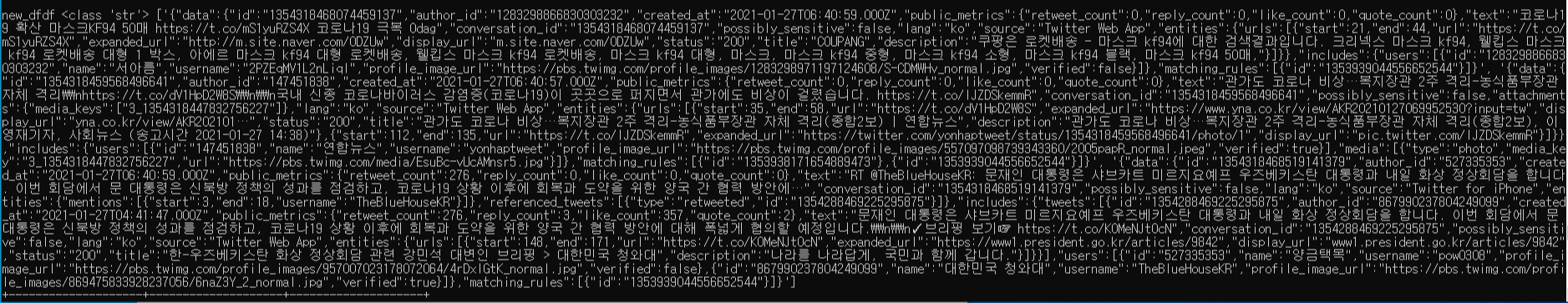

new_dfdf = df.toJSON().collect() print('new_dfdf', type(new_dfdf[0]), new_dfdf)

type이 여전히 string이다 만약 new_dfdf[0]을 출력해보면, '{' 문자가 나온다.

2. 따라서 key와 value로 접근하기 위한 dict로 변환하려면 개별 map에 대해 json.loads로 해주어야 한다.

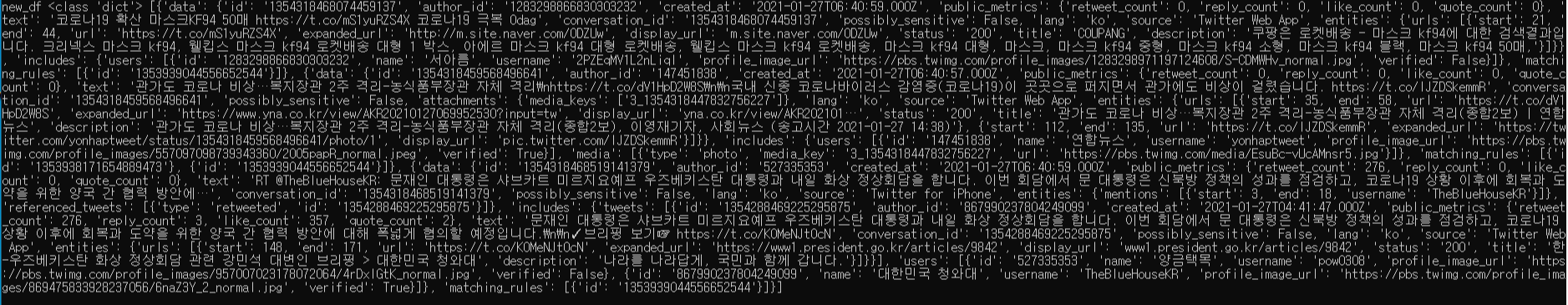

new_df = df.toJSON().map(lambda x: json.loads(x)).collect() print('new_df', type(new_df[0]), new_df)

type이 dict인 것을 확인할 수 있다 - 이상 오늘의 삽질일기 끝!

여기저기 삽질도 해보고

날려도 먹으면서

배우는 게

결국 남는거다

- Z.Sabziller

'DataProcessing > Spark' 카테고리의 다른 글

[Spark] Pyspark 데이터프레임 Shape(column) & Size(row) 구하기 (0) 2021.03.03 [Spark Streaming] PySpark 데이터프레임 모든 컬럼 json으로 변환 & 데이터프레임 딕셔너리 내부 value값 dict 변환 (2) 2021.02.25 [Spark Streaming] spark-streaming-kafka 실행 오류 해결 (feat. 파일 경로 옮기기) (0) 2021.02.24 [Spark Streaming] Kafka-Spark Streaming-Cassandra 연동 (feat.pyspark) (0) 2021.02.23 [Spark Streaming] Kafka TransformedDStream 변환하기 (0) 2021.02.19