-

[Spark] Tutorial #1 데이터 조회, 가공 & 데이터프레임 생성DataProcessing/Spark 2021. 1. 24. 23:09

- Text파일 읽어오기 & 라인(row) 수 반환

sclines = sc.textFile("README.md") # 해당 폴더 안에 있는 README.md 파일 읽기lines.count() # 해당 파일 라인 수

-

전체 텍스트 읽기 (collect 함수)

lines.collect()

-

특정 단어 포함한 문장 반환하기

python_in_lines = lines.filter(lambda line: "Python" in line) python_in_lines.collect()

-

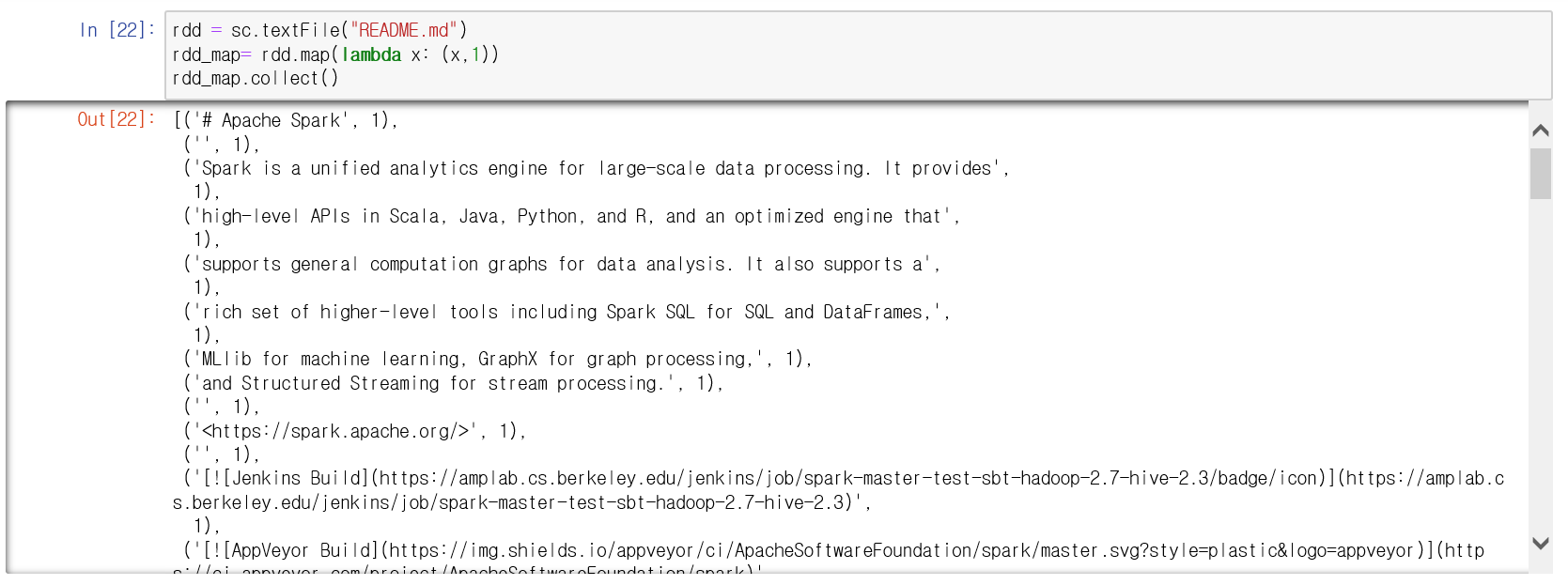

RDD map함수 => 각 데이터 요소에 함수를 적용해 'map' 타입으로 변환

rdd = sc.textFile("README.md")rdd_map = rdd.map(lambda x: (x,1))rdd_map.collect()

-

첫 5문장 조회하기

rdd.take(5)

-

python list를 spark 클러스터로 변환하기

mylist = [1,2,3,4,5]myRDD = spark.sparkContext.parallelize(mylist)myRDD.take(3)

-

DataFrame 생성 및 조회

data = [("James", "Smith", "1991-04-01", "M", 3000), ("Michael", "Rose", "2000-05-19", "M", 4000), ("Robert", "Williams", "1978-09-05", "M", 4000), ("Maria", "Anne", "1994-11-09", "F", 4000), ("Jen", "Mary", "1980-02-17", "F", 5000)]columns = ["firstname", "lastname", "date_of_birth", "gender", "salary"]df = spark.createDataFrame(data=data, schema=columns)df.printSchema() # 데이터프레임 스키마 조회

df.show()

당신이 어떤 것을

할머니에게 설명해주지 못한다면,

그것은 진정으로 이해한 것이 아니다.

- A.Einstein

'DataProcessing > Spark' 카테고리의 다른 글

[Spark] 데이터 가공(Feat. 코로나 Trend분석) (0) 2021.02.17 [환경설정] Spark 설치 및 ubuntu 환경 설정 (feat.AWS) (0) 2021.02.15 [Spark] Trend 분석 연관어 빈도수 구하기 (feat. 불용어 처리) (0) 2021.02.06 [Spark] 스파크 Dataframe 데이터프레임 가공하기 (0) 2021.01.31 [환경설정] spark 스파크 jupyter notebook 실행 설정 (0) 2021.01.17